近日,INTERSPEECH2023会议发出审稿结果通知,数据科学与工业软件课题组2021级硕士研究生王萌威同学以第一作者完成的论文,《TFECN: Time-Frequency Enhanced ConvNet for Audio Classification》,由于大幅提升了卷积神经网络在音频分类任务中的表现,被会议录用。

INTERSPEECH是由国际语音通讯协会(ISCA)创办的权威学术会议,也是全球最大的综合性语音领域的科技盛会,在国际上享有极高盛誉并具有广泛的学术影响力,历届INTERSPEECH会议都倍受全球各地语音研究领域人士的关注。

音频分类是音频深度学习中的研究热点问题之一,主要对声音进行分类并预测其类别,可以应用到许多实际场景中。例如,对音乐片段进行分类以识别音乐类型,或通过一组扬声器对短话语进行分类以根据声音识别说话人。

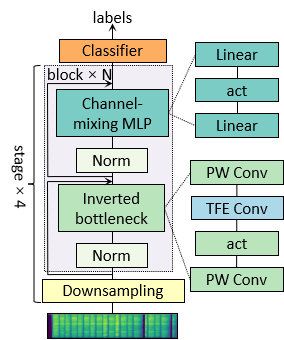

在过去的很长一段时间里,卷积神经网络一直是这个问题的主流模型。但是最近几年,其主导地位似乎正在被Transformer模型取代。为了证明一个纯粹的卷积神经网络依然可以实现领先的性能,王萌威同学结合Transformer模型中的通用架构设计,并改进了音频谱图特征的卷积方法,提出了Time-Frequency Enhanced ConvNet (TFECN)模型。

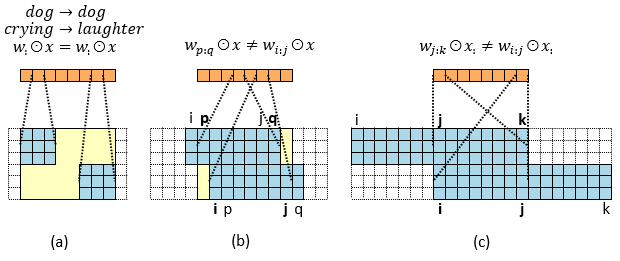

TFECN不仅可以释放卷积在频率维的平移等变性,避免对识别音频特征中的时频模式产生不利影响,同时也提供了频率维的全局感受野,以一种极其简单的方式实现了Transformer中复杂的设计。此外,为了使用预训练模型提供的权重,TFECN采用了一种将小尺寸卷积核中权重迁移至更大卷积核的方法,使得一些使用大卷积核的模型能够利用与其结构类似的,但使用更小卷积核的模型来进行迁移学习。

实验表明,TFECN在三个音频分类任务常用的数据集AudioSet、FSD50K、ESC50中,大幅领先先前的卷积网络模型,并优于以相同方式训练的Transformer模型,证明了一个纯粹的卷积神经网络依然可以在音频分类任务中实现先进的性能。